Marc Ribas

Hace unos ocho años, un compañero de trabajo me hizo una pregunta sobre el software que desarrollábamos en ese momento:

“¿Crees que este programa en el que trabajamos acabará siendo sustituido por la inteligencia artificial?”

En ese momento no habría pensado que estuviéramos tan cerca de una revolución tecnológica como la que vivimos desde hace unos años, ha transformado de forma profunda prácticamente todos los ámbitos de nuestra vida.

Obviamente el sistema RPA (Robotic Process Automation) en el que trabajábamos ha perdido protagonismo, todavía se utiliza para automatizar tareas repetitivas, pero se transforma y, en muchos casos, queda superado por enfoques más flexibles capaces de entender el contexto y adaptarse al cambio.

En este artículo daremos respuesta a las siguientes preguntas:

¿Qué nos depara hoy? ¿Qué dirección está tomando? ¿Cómo debemos prepararnos para este nuevo contexto?

Durante los últimos años, la inteligencia artificial se ha asociado sobre todo a chats que responden preguntas y resuelven problemas. Pero ese paradigma está cambiando rápidamente. Lo que estamos viendo hoy y que se afianza aún más, es una nueva fase, una relación entre la tecnología y las personas, una colaboración directa.

Esta nueva relación la protagonizan los agentes, sistemas capaces de asumir objetivos, ejecutar tareas complejas e interactuar con otras herramientas, servicios e incluso personas. A diferencia de las automatizaciones clásicas, estos agentes no se limitan a seguir reglas fijas, sino que pueden planificar, verificar resultados y ajustarse al contexto. Esto permite que equipos pequeños y personas multipliquen su alcance optimizando los recursos.

En el sector del desarrollo software, es tendencia y es algo que cada vez se está integrando más: los agentes escriben código, lo prueban, formatean y validan antes de que una persona intervenga. Sin embargo, lo más relevante es que este mismo patrón se está extendiendo a otros ámbitos como la gestión documental como Microsoft Copilot o IBM Watsonx, el análisis de datos como por ejemplo Power BI Copilot o Databricks. UiPath o Power Automate en la orquestación de flujos de trabajo enteros, especialmente en organizaciones complejas.

Por todo ello, el rol de los profesionales está cambiando, se transforman en los arquitectos de su trabajo, establecen objetivos, diseñan, supervisan el proceso y validan sus resultados; mientras, los agentes de inteligencia artificial ejecutan el trabajo repetitivo y el humano interviene donde conviene. Este cambio abre las puertas a formas de trabajo más eficientes, escalables y adaptables a las necesidades reales de cada organización.

Este cambio de rol se ha visto materializado, como no podría ser de otra forma, en la construcción de software. El desarrollo de código ha evolucionado del vibe coding* a un protocolo de validación de objetos (Objective-Validation Protocol).

Para que se pueda hacer una idea, la actividad en plataformas como GitHub alcanzó cifras históricas el año pasado, cada mes se integraron cerca de 43 millones de solicitudes de cambio, un 23 % más que el año anterior, y el número anual de commits creció un 25 % hasta llegar a los 1.000 millones. .

*Vibe coding: sin saber de código, programar por intuición con la ayuda de herramientas de inteligencia artificial

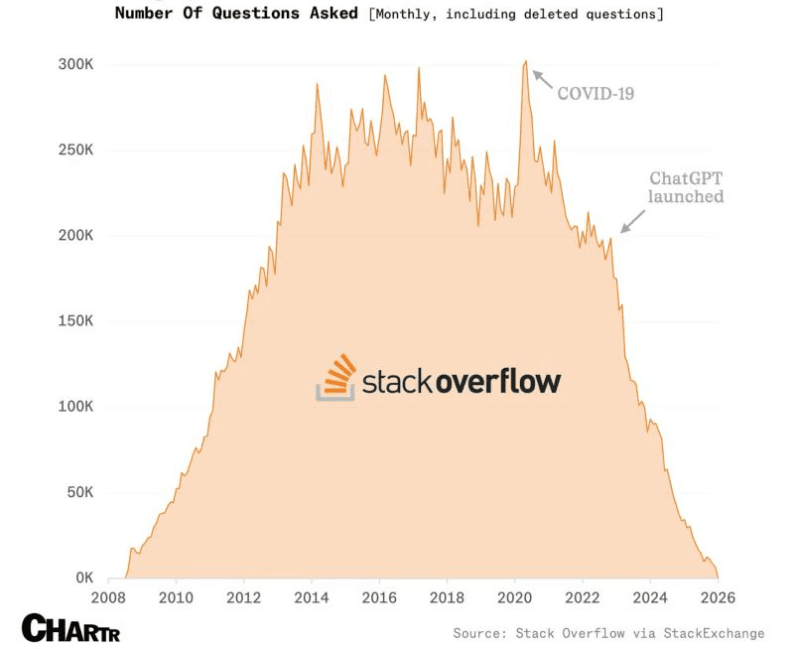

Fuente: CHARTER. Datos: Stack Overflow (vía Stack Exchange).

Fuente: CHARTER. Datos: Stack Overflow (vía Stack Exchange).

Este ritmo, nunca visto hasta ahora, refleja un cambio profundo en la forma de crear software, los usuarios definen los objetivos y las validan mientras los agentes autónomamente ejecutan solicitando la aprobación humana en puntos de control críticos.

La clave no es sólo que la inteligencia artificial escriba código, sino que ha aprendido el lenguaje del software como sistema vivo. Es decir, no entiende sólo líneas de código, sino también su evolución, el contexto, las dependencias y las decisiones que están detrás. Este enfoque, que algunos ya llaman Repository Intelligence, permite a la inteligencia artificial analizar repositorios enteros y comprender lo que ha cambiado, por qué se ha hecho y cómo encaja dentro del conjunto del proyecto.

Fuente: GitHub Copilot Agent Mode

Fuente: GitHub Copilot Agent Mode

Un ejemplo muy claro de Repository Intelligence sería GitHub Copilot con su nuevo modo de agente (Copilot Coding Agent), que puede analizar un código base, generar y refactorizar cambios en múltiples archivos y abrir pull requests automático.

Gracias a esta capacidad contextual, la inteligencia artificial puede ofrecer sugerencias más precisas, detectar errores antes de que lleguen a producción y automatizar correcciones rutinarias que antes requerían tiempo y atención humana.

Tal y como vemos la tendencia, los agentes de inteligencia artificial tendrán un papel cada vez más relevante en nuestro trabajo diario, actuando como socios digitales en procesos operativos y de toma de decisiones. En este contexto, generar confianza no es sólo una cuestión técnica, sino también de gobernanza de negocio.

Cada agente debe disponer de una identidad clara, permisos bien definidos y límites estrictos sobre la información y los sistemas a los que puede acceder, alineados con las políticas, responsabilidades y objetivos de la organización.

Sin este marco de gobernanza, los agentes pueden introducir riesgos operativos y legales difíciles de controlar.

Por eso, la seguridad debe ser integrada desde el inicio y funcionar de forma continua, combinando controles técnicos con criterios de negocio. En un escenario en el que la inteligencia artificial también se utiliza para atacar, sólo una seguridad bien gobernada permitirá aprovechar el potencial de los agentes sin comprometer la confianza ni la sostenibilidad de la organización.

En un entorno de inteligencia artificial y agentes automáticos, entender cómo funcionan es vital. Sin ese conocimiento, podemos volvernos dependientes, manipulables o acabar tomando decisiones basadas en procesos opacos que no controlemos.

Automatizar o crear sin comprender el proceso es un error clásico. General Motors ya lo vivió en los 80, cuando hizo una gran inversión en robots industriales que no aportaron los beneficios esperados. El problema no eran las máquinas, sino que los procesos humanos nunca se entendieron ni se simplificar previamente. Los robots no supieron resolver problemas porque éstos ya existían en el flujo de trabajo original.

Avanzar sin entender el flujo real de trabajo no sólo replica errores, sino que los acelera y amplifica las disfunciones existentes. Los modelos de lenguaje ya influyen en la forma en que pensamos y tomamos decisiones. Nos indican qué buscar, nos ayudan a escribir, nos sugieren opciones y, a menudo, nos conducen a determinadas conclusiones.

Todo esto lo hacen con mucha seguridad, incluso cuando se equivocan. Esta confianza aparente puede empujarnos hacia conclusiones sin que nos demos cuenta. Además, estos modelos están diseñados con intereses (de empresa, producto, contexto) que desde fuera no siempre son visibles. Es como hablar con alguien muy elocuente, a veces se inventa cosas y te lleva por un camino, que bajo tu criterio, no habrías escogido.

Avanzar sin entender el flujo real de trabajo no sólo replica errores, sino que los acelera y amplifica las disfunciones existentes.

Aquí es donde entra en juego la seguridad cognitiva. No se trata de paranoia ni de rechazar la inteligencia artificial, sino de proteger nuestra forma de pensar. Implica entender cómo funcionan los modelos, saber cuándo nos están influenciando y no aceptar recomendaciones sin cuestionarlas.

Toyota lo tuvo claro con su filosofía Jidoka: primero dominar el proceso manual, detectar errores, detener cuando sea necesario, corregir y sólo entonces dejar que la máquina haga el trabajo repetitivo. Esta misma lógica debe aplicarse con la inteligencia artificial.

Esto significa documentar y perfeccionar los flujos de trabajo, validar los datos, definir puntos de control críticos y formar a los equipos para que entiendan tanto el proceso como los riesgos asociados al uso de la inteligencia artificial.

La seguridad cognitiva combina alfabetización digital, control de procesos y gobernanza, y nos recuerda que nosotros como trabajadores debemos ser autocríticos, cuestionar las recomendaciones de los modelos y no delegar ciegamente nuestra forma de pensar en una máquina.

Sólo así podemos aprovechar a los agentes de inteligencia artificial como compañeros de trabajo fiables, evitando amplificar errores, maximizar su potencial y mantener nuestra autonomía intelectual.

En un mundo saturado de inteligencia artificial aprender a entenderla es algo más que una afición, es supervivencia, es autodefensa mental.

Ahora que ya entendemos los procesos y hemos profundizado en entender qué es la inteligencia artificial y cómo funciona, identificamos una tendencia que se da cada vez más a nivel mundial: la desmitificación de la inteligencia artificial.

Después de años de euforia, promesas y grandes titulares, tanto profesionales como usuarios estamos entrando en una fase de desencanto más silenciosa, pero también más madura: según el informe de McKinsey & Company 88% de organizaciones utilizan la inteligencia artificial, sólo un 39% reportan algún impacto tangible en el beneficio operativo, y la mayoría todavía se encuentran en fases piloto que no se han ampliado con éxito.

Profesionales y usuarios comienzan a mostrar desgaste frente a herramientas que prometen mucho pero se integran mal en los flujos reales, funcionalidades con inteligencia artificial añadidas por moda y automatizaciones con ésta que generan ruido que valor.

Muchos profesionales están cansados de sentir que serán sustituidos si no adoptan inmediatamente cualquier herramienta nueva con inteligencia artificial, o implementar inteligencia artificial en un proceso que es totalmente innecesario hacerlo y cuyo coste se triplica en comparación con otras técnicas, o tener que justificar una y otra vez por qué automatizar decisiones críticas sin contexto puede generar más problemas que beneficios.

A esto se le suma la presión constante de incorporar funcionalidades de inteligencia artificial sólo porque la competencia lo hace, aunque el valor aportado sea mínimo o inexistente. El resultado es un ecosistema lleno de funcionalidades de inteligencia artificial poco pensadas, superficiales ya menudo prescindibles.

Pero es precisamente en ese escenario de saturación donde aparece una oportunidad clara. Los que realmente pueden diferenciarse son los profesionales y organizaciones que han entendido sus procesos antes de automatizarlos y aplican pensamiento crítico. Mientras algunos añaden inteligencia artificial de forma indiscriminada, otros la utilizan con intención, sólo donde aporta valor real. Y es aquí donde existe una clara ventaja.

La inteligencia artificial no nos sustituye, pero sí transforma profundamente la forma en que trabajamos. Los agentes ya están con nosotros, y nuestro rol evoluciona de la ejecución repetitiva a la supervisión. Nos convertimos en arquitectos de nuestro trabajo.

La ventaja no estará en quien utiliza la inteligencia artificial, sino en quien sabe por qué, cuándo y cómo hacerlo. La inteligencia artificial amplifica lo que ya somos, y por eso el criterio, la comprensión profunda y la responsabilidad siguen siendo humanos.

La inteligencia artificial es nuestro próximo compañero de trabajo. Y como con cualquier compañero, la clave está en saber trabajar juntos.