Marc Ribas

Fa uns vuit anys, un company de feina em va fer una pregunta sobre el software que desenvolupàvem en aquell moment:

“Creus que aquest programa en el que treballem acabarà sent substituït per la intel·ligència artificial?”

En aquell moment no hauria pensat que estiguéssim tan a prop d’una revolució tecnològica com la que vivim desde fa uns anys, ha transformat de manera profunda pràcticament tots els àmbits de la nostra vida.

Òbviament el sistema RPA (Robotic Process Automation) en el que treballàvem ha perdut protagonisme, encara s’utilitza per automatitzar tasques repetitives, però es transforma i, en molts casos, queda superat per enfocaments més flexibles capaços d’entendre el context i adaptar-se al canvi.

En aquest article donarem resposta a les següents preguntes:

Què ens depara avui? Quina direcció està prenent? Com ens hem de preparar per aquest nou context?

Durant els últims anys, la intel·ligència artificial s’ha associat sobretot a xats que responen preguntes i resolen problemes. Però aquest paradigma està canviant ràpidament. El que estem veient avui i que es consolida encara més, és una nova fase, una relació entre la tecnologia i les persones, una col·laboració directa.

Aquesta nova relació la protagonitzen els agents, sistemes capaços d’assumir objectius, executar tasques complexes i interactuar amb altres eines, serveis i fins i tot persones. A diferència de les automatitzacions clàssiques, aquests agents no es limiten a seguir regles fixes, sinó que poden planificar, verificar resultats i ajustar-se al context. Això permet que equips petits i persones multipliquin el seu abast optimitzant els recursos.

En el sector del desenvolupament software, és tendència i és quelcom que cada cop s'està integrant més: els agents escriuen codi, el proven, el formategen i el validen abans que una persona hi intervingui. El més rellevant, però, és que aquest mateix patró s’està estenent a altres àmbits com la gestió documental com Microsoft Copilot o IBM Watsonx, l’anàlisi de dades com per exemple Power BI Copilot o Databricks, o ServiceNow, UiPath o Power Automate en l’orquestració de fluxos de treball sencers, especialment en organitzacions complexes.

És per tot això que el rol dels professionals està canviant, es transformen en els arquitectes de la seva feina, estableixen objectius, dissenyen, supervisen el procés i en validen els resultats; mentrestant, els agents d’intel·ligència artificial executen la feina repetitiva i l’humà intervé on convé. Aquest canvi obre les portes a formes de treball més eficients, escalables i adaptables a les necessitats reals de cada organització.

Aquest canvi de rol s’ha vist materialitzat, com no podria ser d'una altra manera, en la construcció de software. El desenvolupament de codi ha evolucionat del vibe coding* a un protocol de validació d’objectes (Objective-Validation Protocol).

Perquè us pugueu fer una idea, l’activitat a plataformes com GitHub va assolir xifres històriques l’any passat, cada mes es van integrar prop de 43 milions de sol·licituds de canvi, un 23 % més que l’any anterior, i el nombre anual de commits va créixer un 25 % fins a arribar als 1.000 milions.

*Vibe coding: sense saber de codi, programar per intuïció amb l’ajuda d’eines d'intel·ligència artificial

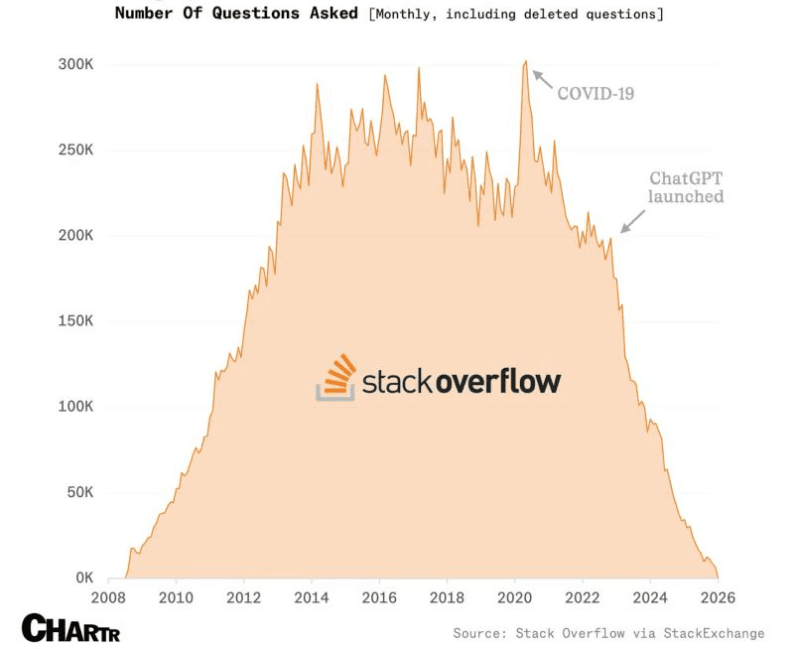

Font: CHARTER. Dades: Stack Overflow (vía Stack Exchange).

Font: CHARTER. Dades: Stack Overflow (vía Stack Exchange).

Aquest ritme, mai vist fins ara, reflecteix un canvi profund en la manera de crear software, els usuaris defineixen els objectius i les validen mentre els agents autònomament executen sol·licitant l'aprovació humana en punts de control crítics.

La clau no és només que la intel·ligència artificial escrigui codi, sinó que ha après el llenguatge del software com a un sistema viu. És a dir, no entén només línies de codi, sinó també la seva evolució, el context, les dependències i les decisions que hi ha al darrere. Aquest enfocament, que alguns ja anomenen Repository Intelligence, permet a la intel·ligència artificial analitzar repositoris sencers i comprendre què ha canviat, per què s’ha fet i com encaixa dins del conjunt del projecte.

Font: GitHub Copilot Agent Mode

Font: GitHub Copilot Agent Mode

Un exemple molt clar de Repository Intelligence sería GitHub Copilot amb el seu nou mode d’agent (Copilot Coding Agent), que pot analitzar un codi base, generar i refactoritzar canvis en múltiples fitxers i obrir pull requests automàticament amb comprensió del context general del projecte.

Gràcies a aquesta capacitat contextual, la intel·ligència artificial pot oferir suggeriments més precisos, detectar errors abans que arribin a producció i automatitzar correccions rutinàries que abans requerien temps i atenció humana.

Tal i com veiem la tendència, els agents d’intel·ligència artificial tindran un paper cada cop més rellevant en el nostre treball diari, actuant com a **socis digitals **en processos operatius i de presa de decisions. En aquest context, generar confiança no és només una qüestió tècnica, sinó també de governança de negoci.

Cada agent ha de disposar d’una identitat clara, permisos ben definits i límits estrictes sobre la informació i els sistemes als quals pot accedir, alineats amb les polítiques, responsabilitats i objectius de l’organització.

Sense aquest marc de governança, els agents poden introduir riscos operatius i legals difícils de controlar.

Per això, la seguretat ha de ser integrada des de l’inici i funcionar de manera contínua, combinant controls tècnics amb criteris de negoci. En un escenari on la intel·ligència artificial també s’utilitza per atacar, només una seguretat ben governada permetrà aprofitar el potencial dels agents sense comprometre la confiança ni la sostenibilitat de l’organització.

En un entorn d’intel·ligència artificial i agents automàtics, entendre com funcionen és vital. Sense aquest coneixement, podem tornar-nos dependents, manipulables o acabar prenent decisions basades en processos opacs que no controlem.

Automatitzar o crear sense comprendre el procés és un error clàssic. General Motors ja ho va viure als anys 80, quan va fer una gran inversió en robots industrials que no van aportar els beneficis esperats. El problema no eren les màquines, sinó que els processos humans mai es van entendre ni simplificar prèviament. Els robots no van saber resoldre problemes perquè aquests ja existien en el flux de treball original.

Avançar sense entendre el flux real de treball no només replica errors, sinó que els accelera i amplifica les disfuncions existents. Els models de llenguatge ja influeixen en la manera com pensem i prenem decisions. Ens indiquen què buscar, ens ajuden a escriure, ens suggereixen opcions i, sovint, ens condueixen cap a determinades conclusions.

Tot això ho fan amb molta seguretat, fins i tot quan s’equivoquen. Aquesta confiança aparent pot empènyer-nos cap a conclusions sense que ens n’adonem. A més, aquests models estan dissenyats amb interessos (d’empresa, de producte, de context) que des de fora no sempre són visibles. És com parlar amb algú molt eloqüent, de vegades s’inventa coses i et porta per un camí, que sota el teu criteri, no hauries escollit.

Avançar sense entendre el flux real de treball no només replica errors, sinó que els accelera i amplifica les disfuncions existents.

Aquí és on entra en joc la seguretat cognitiva. No es tracta de paranoia ni de rebutjar la intel·ligència artificial, sinó de protegir la nostra manera de pensar. Implica entendre com funcionen els models, saber quan ens estan influenciant i no acceptar recomanacions sense qüestionar-les.

Toyota ho va tenir clar amb la seva filosofia Jidoka: primer dominar el procés manual, detectar errors, aturar quan calgui, corregir i només llavors deixar que la màquina faci la feina repetitiva. Aquesta mateixa lògica s’ha d’aplicar amb la intel·ligència artificial.

Això vol dir documentar i perfeccionar els fluxos de treball, validar les dades, definir punts de control crítics i formar els equips perquè entenguin tant el procés com els riscos associats a l’ús de la intel·ligència artificial.

La seguretat cognitiva combina alfabetització digital, control de processos i governança, i ens recorda que nosaltres com a treballadors hem de ser autocrítics, qüestionar les recomanacions dels models i no delegar cegament la nostra manera de pensar a una màquina.

Només així podem aprofitar els agents d’intel·ligència artificial com a companys de feina fiables, evitant amplificar errors, maximitzar el seu potencial i mantenir la nostra autonomia intel·lectual.

En un món saturat de intel·ligència artificial aprendre a entendre-la és més que una afició, és supervivència, és autodefensa mental.

Ara que ja entenem els processos i hem aprofundit en entendre què és la inteligencia artificial i com funciona, identifiquem una tendencia que es dona cada cop més a nivell mundial: la desmitificació de la inteligencia artificial.

Després d’anys d’eufòria, promeses i grans titulars, tant professionals com usuaris estem entrant en una fase de desencant més silenciosa, però també més madura: segons l’informe The State of AI in 2025 de McKinsey & Company, tot i que un 88 % d’organitzacions utilitzen Iinteligencia artificial, només un 39 % reporten algun impacte tangible en el benefici operatiu, i la majoria encara es troben en fases pilot que no s’han ampliat amb èxit.

Professionals i usuaris comencen a mostrar desgast davant d'eines que prometen molt però s’integren malament als fluxos reals, funcionalitats amb inteligencia artificial afegides per moda i automatitzacions amb aquesta que generen soroll que valor.

Molts professionals estan cansats de sentir que seran substituïts si no adopten immediatament qualsevol eina nova amb inteligencia artificial, o implementar inteligencia artificial en un procés que es totalment innecesari fer-ho i el cost es triplica en comparació amb altres tècniques , o haver de justificar una vegada i una altra per què automatitzar decisions crítiques sense context pot generar més problemes que beneficis.

A això s’hi suma la pressió constant d’incorporar funcionalitats d’ intel·ligència artificial només perquè la competència ho fa, encara que el valor aportat sigui mínim o inexistent. El resultat és un ecosistema ple de funcionalitats d’ intel·ligència artificial poc pensades, superficials i sovint prescindibles.

Però és precisament en aquest escenari de saturació on apareix una oportunitat clara. Els que realment poden diferenciar-se són els professionals i les organitzacions que han entès els seus processos abans d’automatitzar-los i apliquen pensament crític. Mentre alguns afegeixen intel·ligència artificial de manera indiscriminada, d’altres la utilitzen amb intenció, només allà on aporta valor real. I és aquí on hi ha un clar avantatge.

La intel·ligència artificial no ens substitueix, però sí que transforma profundament la manera com treballem. Els agents ja hi són amb nosaltres, i el nostre rol evoluciona de l’execució repetitiva a la supervisió. Ens convertim en arquitectes de la nostra feina.

L’avantatge no estarà en qui utilitza l'intel·ligència artificial, sinó en qui sap per què, quan i com fer-ho. La intel·ligència artificial amplifica allò que ja som, i per això el criteri, la comprensió profunda i la responsabilitat continuen essent humans.

La intel·ligència artificial és el nostre pròxim company de feina. I com amb qualsevol company, la clau està a saber treballar plegats.